四节点百GB吞吐量!超融合迈入全闪时代

随着分布式、私有云、混合云等技术概念逐步成熟并获得越来越广泛的认可,超融合(HCI)基础设施对企业用户的吸引力也不断提高。Gartner的报告指出:超融合已经进入到生产成熟期。

“超融合”简单说就是配置相对完整的服务器,搭配虚拟化软件,构造分布式系统。分布式系统的最大好处是可以将各个服务器中的资源集中调度,减少浪费。同时,又可以尽量本地访问,相对传统的存储服务器,减少了网络压力。

为了直观展示这一特点,我们利用戴尔科技集团发布新一代VxRail软硬件的机会,构建了一套4节点超融合服务器的集群,进行了针对性的测试。

Dell VxRail拥抱全闪

VxRail是一款拥有“中国血统”的产品,由中国研发团队独立设计,整合了Dell的硬件、数据保护软件、VMware vSphere虚拟化和存储软件。

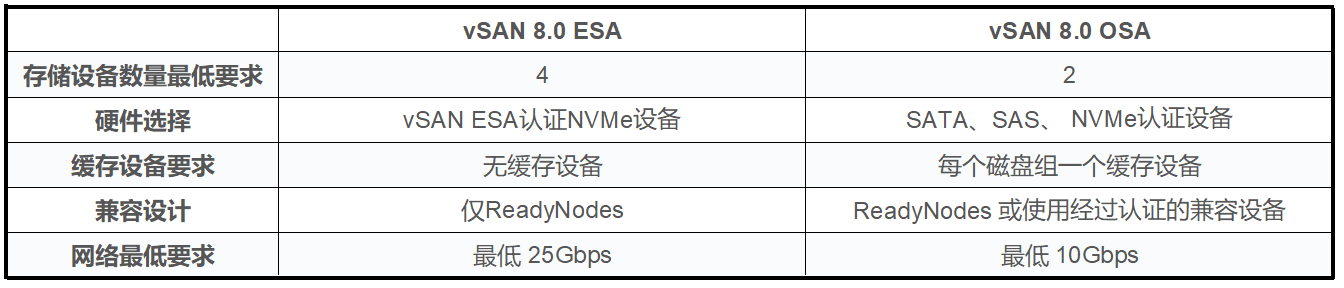

在2023年推出的VxRail 8全面支持VMware vSphere 8和vSAN 8软件,支持运行VMware分布式服务引擎(DSE)和ESA(Express Storage Architecture)技术。

在我看来,vSAN 8 ESA的主要价值点就是取消了缓存SSD的要求,更适合全闪配置,将原有OSA以“磁盘组”形式变为ESA以“存储池”的形式提供存储容量。ESA不再区分缓存盘和容量盘,无磁盘组架构,所有存储设备都有助于提高性能和总体的存储容量,每个节点的所有NVMe SSD共同构建成单层的存储池,同时存储池中任何SSD故障,则该SSD上的数据将快速重建,缩短了故障恢复的时间,提高了系统的可靠性和可用性。

ESA要求每个节点配置4个或更多的TLC SSD,并建议使用25GbE网络。VMWare认为,即使是25GbE网络,也会被vSAN 8 ESA占满,对于性能和延时要求更高的场景,推荐使用100GbE网络。实际上,根据我们此次部署的经验,ESA节点是可以在10GbE网络中运行的,但性能损失也确实较为明显。

在节点数量方面,对于RAID1、RAID5策略,建议的最低节点数量为3个,推荐4个节点起;RAID6最低节点数量为6个,推荐7个节点起。但通过ESXi主机部署见证(Witness)设备,使用2个节点也可以实现RAID1策略——这有利于降低用户部署分布式全闪的门槛。

与vSAN 8 ESA硬件配置门槛大幅提升对应的,现在VxRail的硬件底座也迎来了重大升级:VP-760和VE-660分别基于PowerEdge R760和R660服务器,支持第四代英特尔至强可扩展处理器,性能相对于上一代平台有了全面的提升,如更多的内核、更大的内存带宽、更多的PCIe接口等。

SSD支持方面,从主流的PCIe 4.0 U.2 NVMe,到新锐的EDSFF E3.S(PCIe 5.0),VP-760和VE-660均可适配,可以将存储容量、性能推到新的高度。

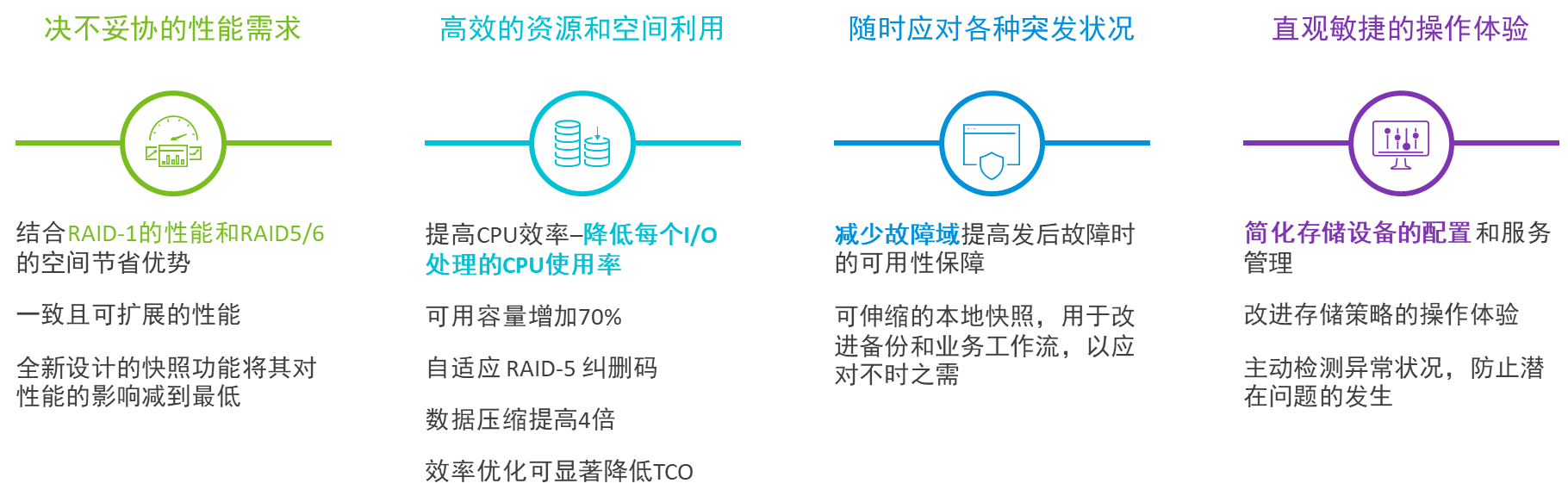

高性能NVMe SSD是vSAN 8 ESA的基石。TLC NVMe SSD的存储设备价格比混闪高,也高于QLC SSD,容量成本也会比传统的超融合基础设施明显增加。ESA的应对方案是利用RAID5/6为代表的纠删码(Erasure Coding)提高容量可用性(较低的冗余消耗),以及默认开启的数据压缩技术(需要消耗一些计算资源)。这两种技术的结合可以减少原始数据在存储设备上占用的空间,从而降低数据存储成本。

用已有的东西做更多的事情来降低 TCO,VxRail vSAN 8 with vSAN Express Storage Architecture™ 价值优势如下:

实测:

配置平平无奇,成绩颇有惊喜

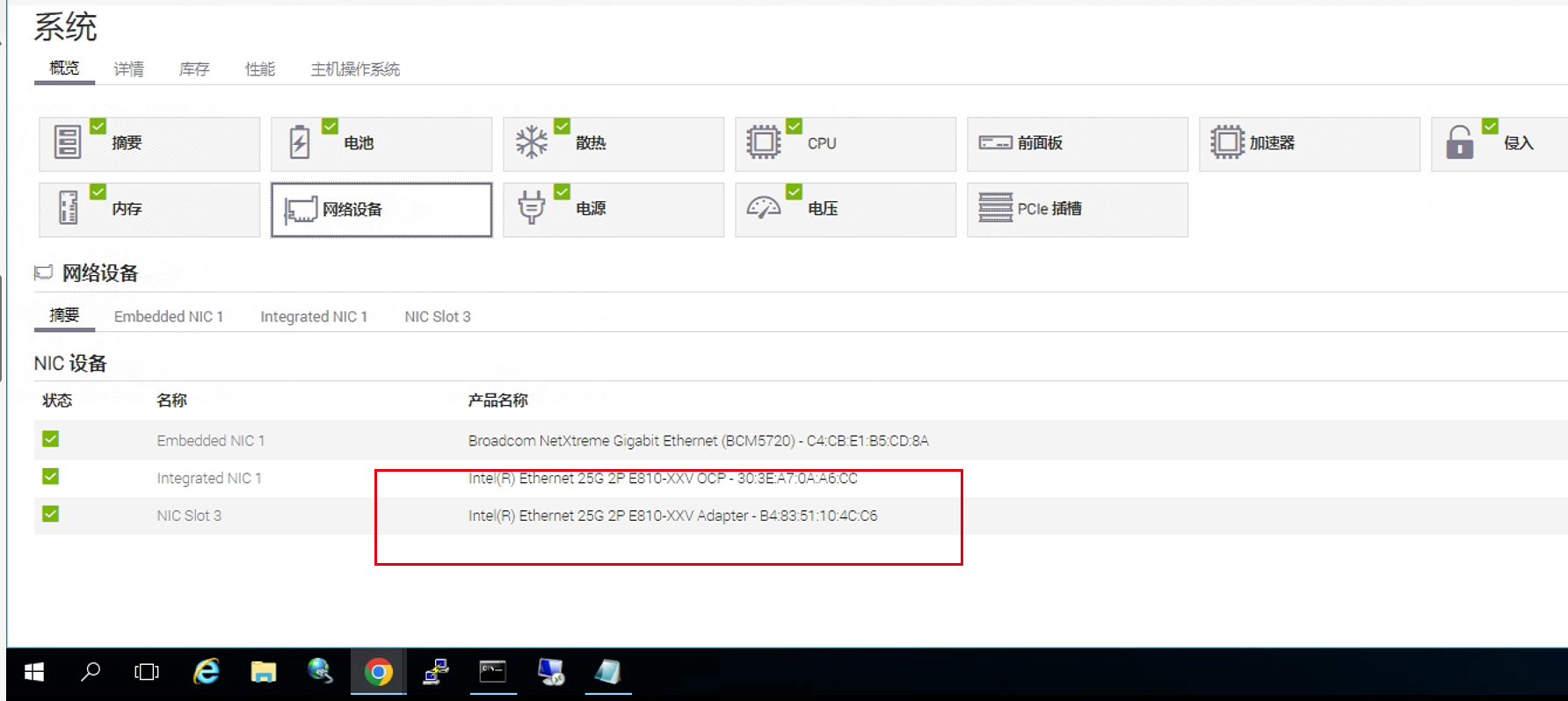

这次针对新一代超融合基础设施的测试使用了4个Dell VxRail VE-660节点。由于“你懂”的原因,我们并没有为了刻意刷数据而使用了高配置:CPU仅是单路16核,内存容量也不大,4通道共256GB。每个节点均配置了4个NVMe SSD用于数据盘,双25GbE网卡,也不过是ESA的基本要求而已。

设备:Dell VxRail VE-660

CPU:单路Intel Xeon Gold 6444Y(16物理核,32逻辑核,3.6GHz)

内存:DDR5 4800 RDIMM 64GB ×4

系统盘:NVMe 960GB ×2

存储盘:Dell Ent NVMe CM6 RI 1.92TB ×4

系统:8.0.1 Update 1 Patch 25 (build-22088125) Kernel 8.0.1 (x86 64)

虚拟机设置:

vCPU数量:4

vDisk容量:10GB

vDisk数量:4或8

集群的存储配置策略分别验证RAID1和RAID5模式,前者理论上将消耗整个集群一半的容量作为副本。每个虚拟机分配4个以上的虚拟盘,有利于将负载更均匀地分散到物理SSD上。设置相对较小的虚拟盘容量可以让我们开启更多的虚拟机和虚拟盘,譬如32个虚拟机各8个虚拟盘就需要分配约5TB的容量。

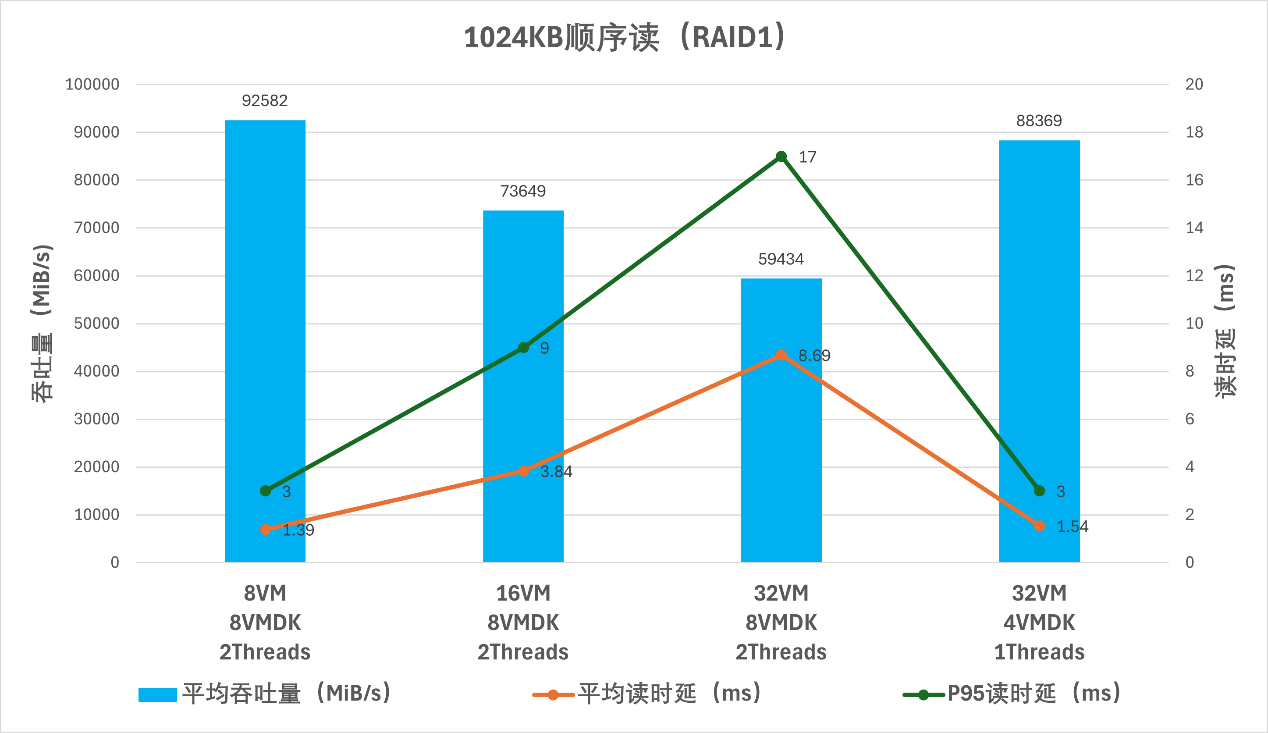

我们通过HCIBench运行FIO测试。先用1MB的大数据块跑顺序读,试探这个集群的吞吐量极限。经过反复测试,在8个虚拟机、每虚拟机8个盘,分配2个FIO线程的情况下,可以达到92.6GB/s的平均吞吐量,峰值吞吐量约95GB/s。

这是什么概念?

这个集群中,16个SSD的顺序读性能理论上约110GB。目前测得的吞吐量达到了理论值的88%。所以,这就是我们开头说的“尽量本地访问,减少网络压力”的意义所在。

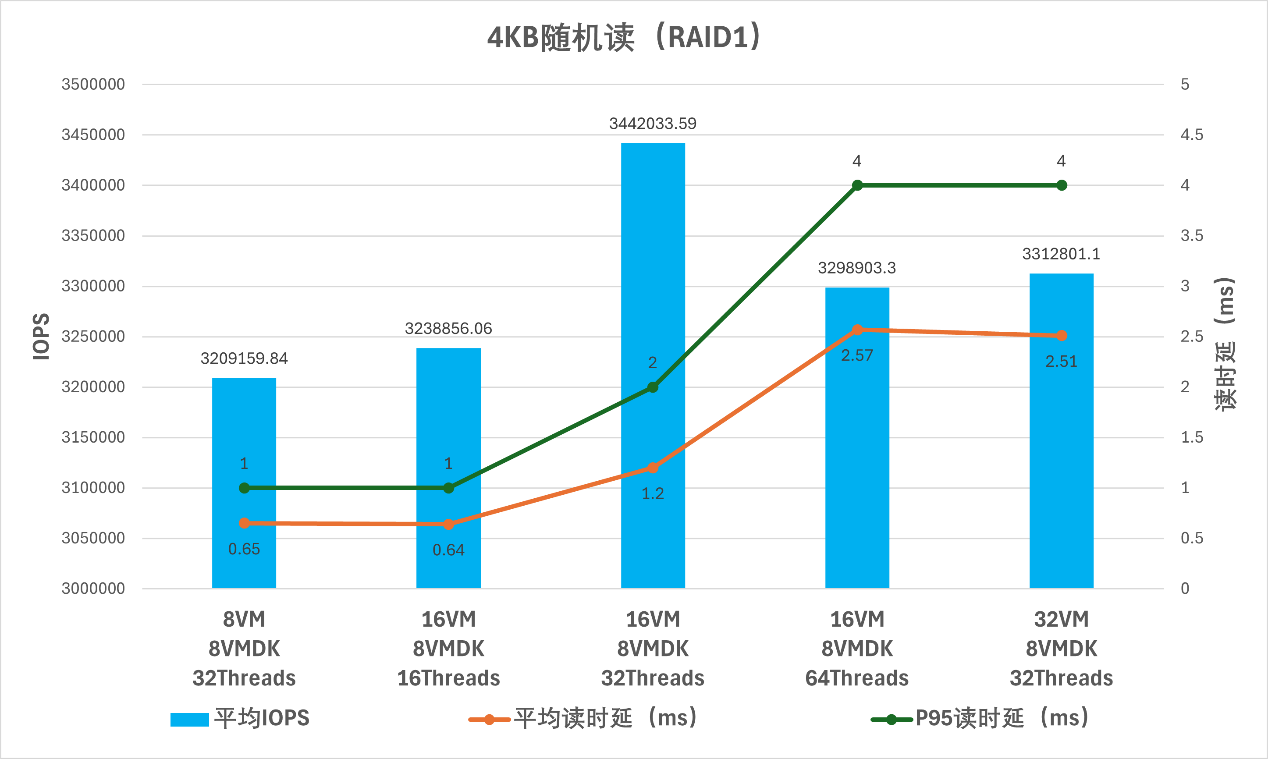

值得一提的是:大吞吐量的操作,对CPU的性能也有很高的要求。一旦虚拟机、虚拟盘、FIO线程的总数过高,会导致CPU占用率过高,增大时延,进而拖累吞吐量。譬如,大流量测试中最大吞吐量的IO配置总数是128(IO总数=虚拟机数×虚拟盘数×FIO线程数=8×8×2=128),正好对应所有处理器物理核数量,平均读延迟仅为1.39毫秒,犹如一对一服务。

我们将同样配置的虚拟机数量翻倍至16个,IO线程数随之倍增至256,控制台中出现了处理器占用率触顶的情况,记录的平均读延迟也倍增到3.84毫秒,平均吞吐量降到约73.6GB/s。进一步将虚拟机增到32个,读延迟将高达8.69毫秒,吞吐量进一步下降到59GB/s。

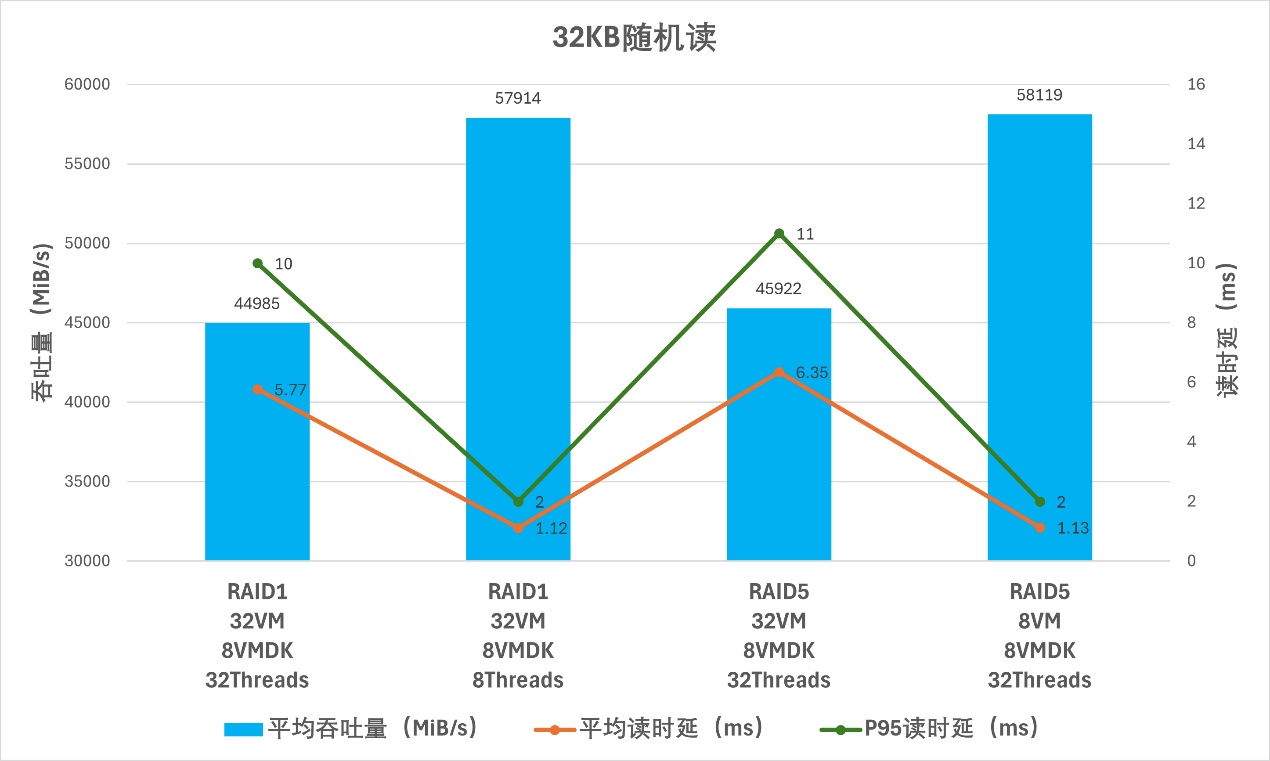

数据库的数据块大小通常设置在8KB~32KB之间。典型超融合应用的数据块平均水平约20~40KB的量级。在我们测试的这个集群当中,32KB随机读访问的吞吐量效率很高,可以超过60GB/s,已经是近似于顺序读的量级。

简而言之,分布式全闪可以提供极高的吞吐量,但对CPU性能也提出了很高的要求——这是传统的超融合设备当中所没有的经验。所幸我们测试的VE-660节点仅是基本配置,还预留了充足的扩展空间。随着业务负载的提升,完全可以选配更多核数的处理器,增加处理器数量(双路),进一步增加节点数量等等。

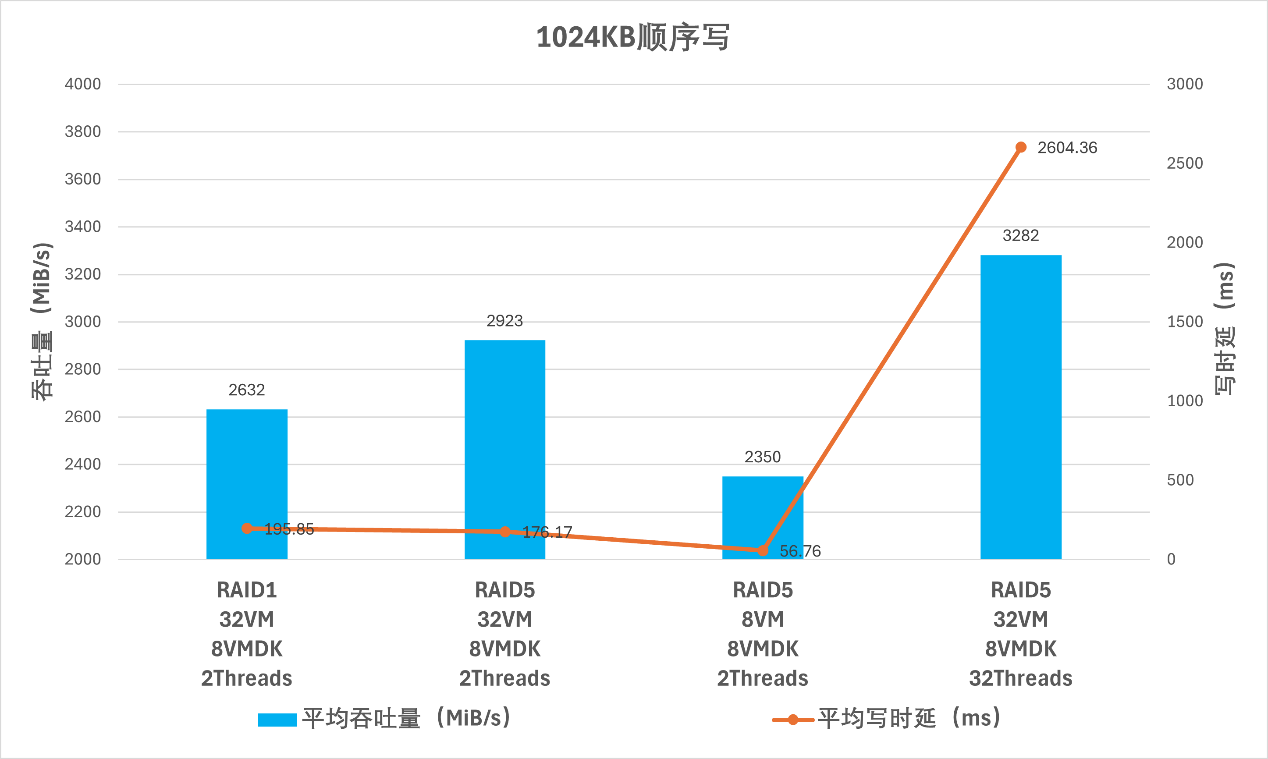

顺序写的测试则体现了分布式全闪对网络带宽的要求。由于vSAN8 ESA的数据副本是跨节点写入的,因此,写操作的吞吐量将受限于网络端口。目前我们配置的是25GbE网络,总体的写入吞吐量也相应的被限制在了3GB/s左右的水平。RAID1策略由于过多的副本容量消耗,还导致其吞吐量明显低于RAID5策略下的同等虚拟机配置。

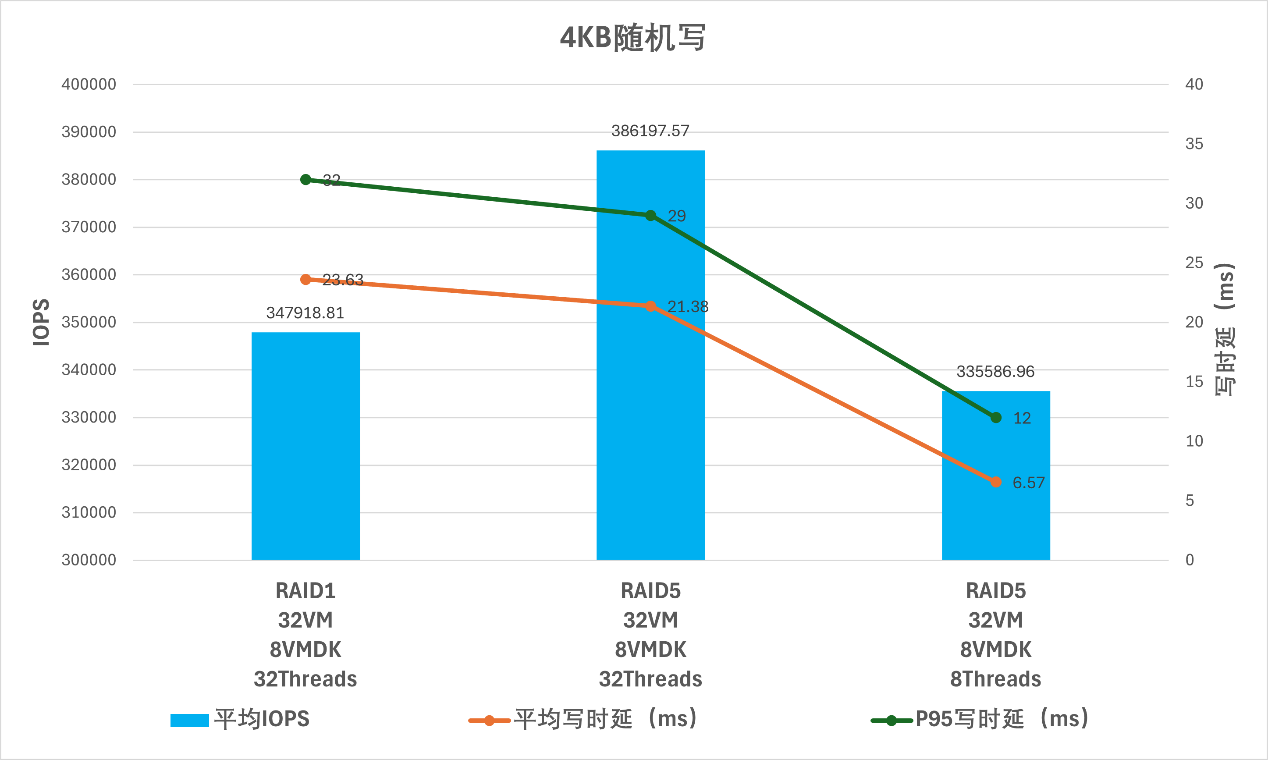

随机读方面,在RAID1策略下可以获得331万IOPS,对应的吞吐量约13GB/s。随机写方面,RAID5策略会有更高的IOPS,同样的虚拟机和测试配置,平均IOPS可以达到38.6万,相对的,RAID1为34.8万。

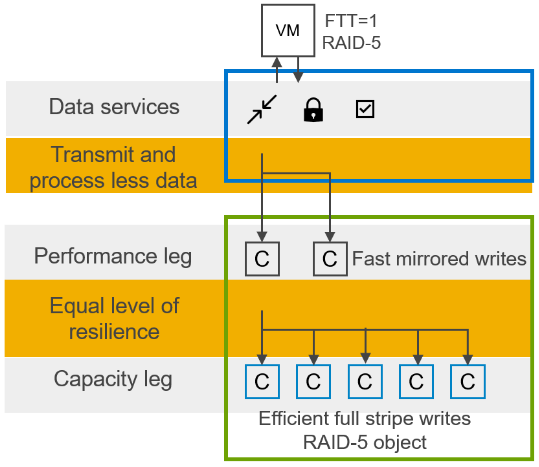

在随机写测试中,RAID 5的时延优势也显现出来。传统观念中,RAID5的写入需要跨越更多的磁盘,按说会带来更高的时延,为何在此出现了相反的测试结果?这里就必须专门分析一下vSAN 8 ESA对RAID 5/6写性能的改进。简单的说,ESA中RAID 5/6的写入被分成三个阶段:

阶段零,是主机对传输的数据进行预处理,包括压缩、去重等操作,这部分是可以在配置时进行调整的;

阶段一,数据先以RAID 1即副本的方式写入SSD上被称为“Performance Leg”的暂存区;

阶段二,经后台计算出校验数据后,一并写入到被称为“Capacity Leg”的持久化存储区域。

按照我个人的理解,这颇有些类似以前的“回写”(write-back)与“透写”(write-through),由于在第一阶段的写入完成后,就向发起请求的客户机(VM)返回写确认信息,所以RAID 5的写入不会带来额外的时延开销,我们的测试数据也证明了这一点:ESA的RAID 5拥有比RAID 1更高的存储空间利用率,还有同等的读性能、更高的写性能。

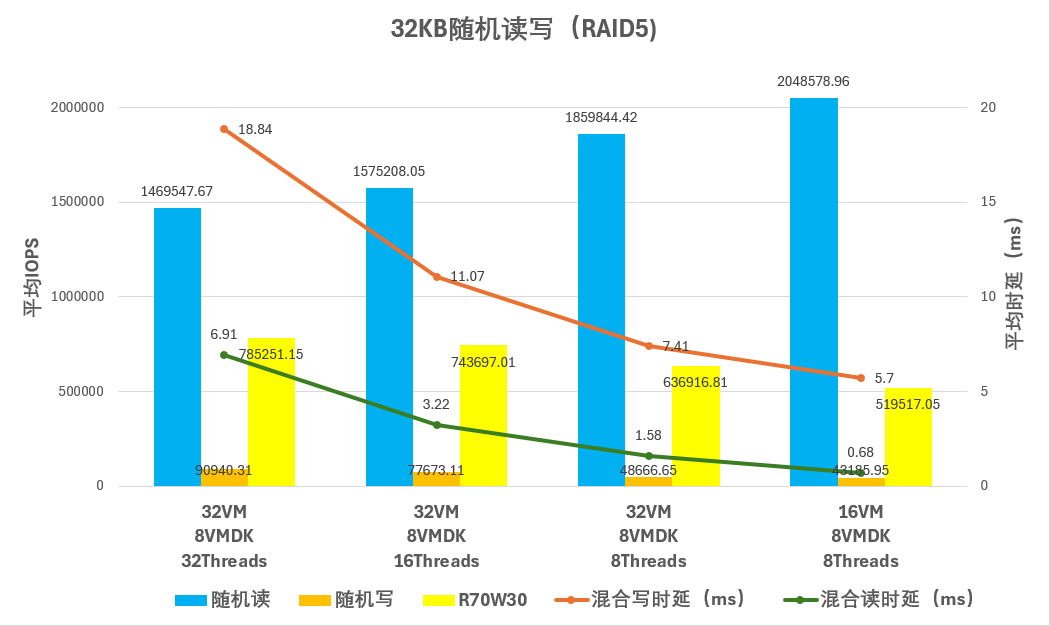

混合读写方面,我们使用了32KB数据块,70%读、30%写的比例。在纯读纯写的测试中,我们发现:这个分布式集群的纯随机读性能与随机写性能,分别与总IO数量的关系,是相反的。对于读测试,较少的虚拟机或线程数量,有利于获得较大的IOPS,这与顺序读的趋势相同;而对于写测试,较多的虚拟机和线程数量会获得更高的IOPS,但时延也会明显增加。那么,混合读写与IO数量将是什么关系呢?我们将100%读、100%写、7:3混合读写的IOPS汇集在同一个柱状图中,结论是:混合读写的性能趋势与随机写相同,较高的IO总量与IOPS正相关。这说明写操作的时延对于全局影响更大。不同的应用场景对性能的需求是有不同的侧重点的,读写可能难以两全,时延与吞吐量之间是矛盾的关系。具体到这组测试而言,重点关注混合读写的总吞吐量的话,32个虚拟机、8个虚拟盘、32个FIO线程配置的成绩较为均衡。

结语

新一代Dell VxRail的软、硬件均有了巨大提升。新的Vsan8 ESA体系架构针对NVMe SSD、DPU等高性能硬件优化,引入的单层全闪存体系简化了设备管理、提高了性能一致性和扩展弹性。参与测试的VE-660节点提供了令人印象深刻的吞吐量,并预留了充裕的扩展空间,包括更高配置的CPU、更多的SSD,甚至100GbE网络等。一体化、本土化的解决方案和领先的性能,将为混合云、边缘计算等场景注入令人惊艳的澎湃动力。