《考察报告》连载十一|液冷、通道隔离对服务器发展的影响

风冷与液冷

如果机柜有较为充足的供电能力,或者数据中心有更强的制冷能力(譬如,液冷)配套,1U 服务器在计算密度上的优势,就更容易发挥出来。在高性能计算(High Performance Computing,HPC)场景,或者大型互联网和云计算公司的数据中心,见到 1U 服务器的机会相对较高。

以百度、阿里、腾讯(BAT)联合英特尔发起的天蝎整机柜项目为例,早期的节点都是 1U 高度,包括存储节点(JBOD)。2018 年数字中国万里行最后一站是百度阳泉数据中心,8.8 千瓦(KW)的 46U 机柜安装多达 35 个 1U 计算节点。

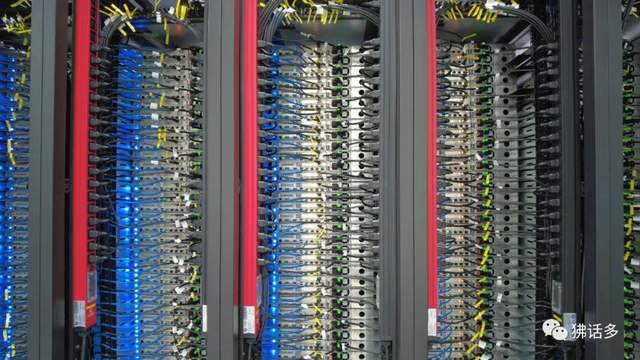

△ 和林格尔东方超算云数据中心内景

在算力篇曾经提过,2017 年推出的 x86 服务器 CPU,高配版本的 TDP 有大幅度的跃升(最高接近50%),而公有云服务提供商倾向于采用这一档次的产品。在这种情况下,如果单机柜的供电能力不能“水涨船高”,1U 节点的密度优势将很难体现。

即使解决了供电问题,还有散热(对数据中心基础设施侧,是”制冷”)的挑战,而这正是液冷的优势。阿里巴巴 2018 年在河北省张家口市张北县部署了一个浸没式液冷(Immersion Cooling)机房,一个卧置的 54U 机柜,部署 32 台 1U 双路服务器和 4 台 4U 的 JBOD,设计功耗 28 千瓦。

△ 中国电子信创云基地(顺义)机房内的 2U 服务器

其他公司多在布局基于冷板(Cold Plate)的“风液混合”冷却技术, 即发热量最大的 CPU 等芯片通过冷板内流经的液体把热量带到机柜外,内存条、硬盘等发热量较低的元件仍然用传统的风冷。以华为乌兰察布云数据中心为例,机房里部署了 20 千瓦的液冷整机柜服务器 FusionPOD,园区内还有相对独立的小型液冷机房 FusionCell,由类似集装箱体的供配电、机柜和制冷模块各一组成。

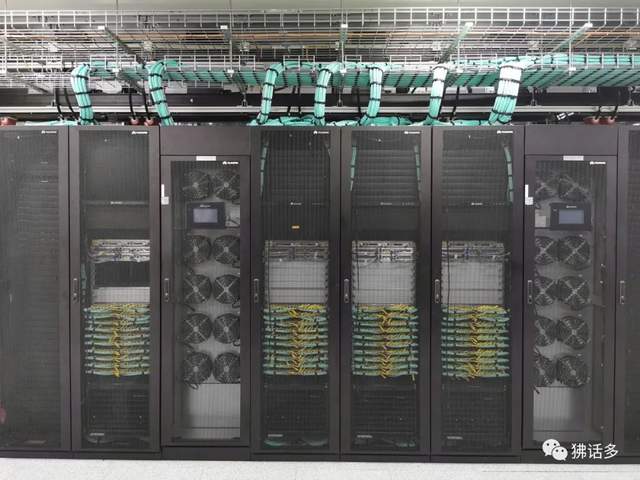

△ 华为云东莞松山湖数据中心部署的 Atlas 900 集群,单机柜功率达 53 千瓦,采用风液混合技术散热

那么,液冷服务器的时代是不是很快就能到来呢?肯定还需要一段时间来过渡,关键是这个过渡的势头如何。

先从数据中心基础设施(风火水电)这一侧来看,近期规划和建设的数据中心,风冷机房仍是绝对主流,液冷机房主要在扩大实验阶段或满足一些特定应用场景如 HPC 和 AI 集群的需求。

如果应用侧并没有硬性需求,那么提高功率密度并引入液冷方案,就必须考虑成本因素。在一个风冷具有天然优势的生态里,液冷的 CapEx(资本支出)显然更高,而OpEx(运营成本)也难言优势—— 除了PUE(Power Usage Effectiveness,电源使用效率)。

△ Atlas 900 集群的机柜与 CDU(Coolant Distribution Unit,冷液分配单元)

在东数西算的布局中,西部的数据中心,从双碳角度应该有两大优势:一是就地消纳丰富的能源供给,特别是可再生能源(如风能和太阳能);二是气候条件好,可以充分利用自然冷源,降低对电能的消耗。其中,很多符合“西算”标准的数据中心,广泛应用了以间接蒸发制冷为代表的节能方案,在张家口数据中心集群、和林格尔数据中心集群的数据中心,一年有 10 个月以上的时间可以使用自然冷源,年均 PUE 可达 1.2,液冷方案的节能优势并不明显。

以浸没式液冷为例,阿里巴巴目前最大规模的部署其实位于“东数”地带——杭州仁和数据中心有一个全浸没式液冷机房楼。相比之下,张北的一个浸没式液冷机房更符合扩大实验的定位,其他机房还是相对“传统”的风冷方案,更多利用气候条件的自然红利就可以满足要求。华为乌兰察布云数据中心也是以 8 千瓦的风冷机柜为主,何况 20 千瓦的液冷机柜还有部分风冷(风液混合,制冷贡献大抵三七开)。

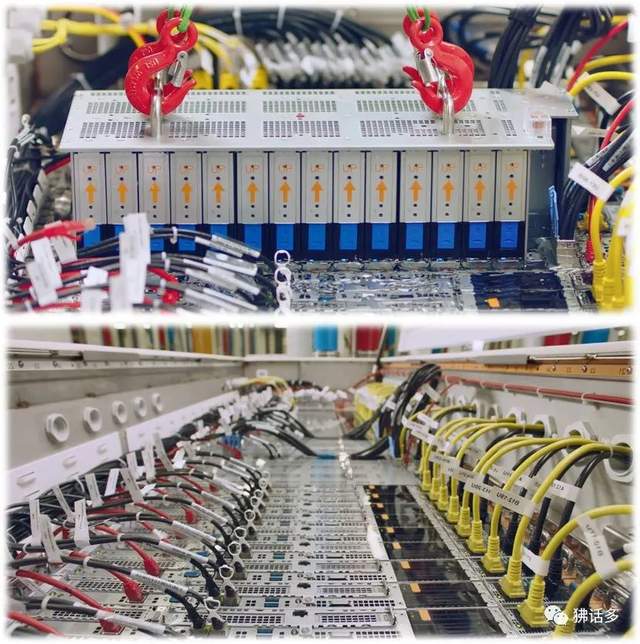

△ 腾讯云星星海服务器的冷板式液冷样机

总之,自然冷源是“西算”相对“东数”的一大优势,能用风冷尽量风冷——后面这句也适用于服务器,因为风冷服务器的环境适应性优势很明显。

从英特尔(Intel)和 AMD 的路线图来看,将于 2022 年推出的新一代 x86 CPU,旗舰型号的核心数不是超过 50 就是接近 100,TDP 都会逾越 300 瓦,落在 300~400 瓦(如cTDP,甚至更高)的区间。CPU 功耗进一步上升对液冷方案当然是个利好,但风冷也不是完全处理不了,采用更强力的风扇、优化内部风道设计等手段,都还管用。

实际上,英特尔在 2019 年已经推出过 TDP 高达 400 瓦的至强铂金(Platinum)9200 系列 CPU,而配套的 Intel Server System S9200WK 家族服务器,在支持 350 瓦 TDP 的 48 核 CPU(Platinum 9242)时,仍然可以使用风冷。需要指出的是,S9200WK 采用半宽节点设计,即 2 个 CPU 前后串列布置,散热效果不如并列布置的好。2U 服务器双 CPU 并列布置,结合T型散热器、强力风扇、优化气流等手段,支持 2 个 400 瓦 TDP 的 CPU,也是可以做到的。

从目前看到的基于英特尔新一代至强可扩展处理器(代号Sapphire Rapids)的服务器设计,风冷依然是可行的。再往后看,未来三年将是服务器从风冷向液冷过渡的关键时期,而冷板式液冷本身的“风液混合”气质也有助于其成为很多用户的首选液冷方案。

在需求侧,工作负载,或者说服务器和机柜的功率,仍然是决定采用液冷的首要因素。特别是大量采用 GPU 等高密度加速计算单元的服务器,即使风冷还能应付过来,改用液冷也会有更好的效果。

在供给侧,部署液冷服务器需要数据中心基础设施(制冷 + 供电)的紧密配合,最好供应商能够提供完整的解决方案。

大型互联网和云计算公司主导的超大规模数据中心,将对液冷服务器的大规模应用产生决定性影响。因为他们既有足够的体量和应用需求,对数据中心(基础设施)建设也有足够的掌控能力。

数字中国万里行也将加大对液冷服务器应用的追踪力度。

热通道与前维护

在《2018 中国超大规模云数据中心考察报告》的第六章,我们介绍了通过提高服务器工作温度来改善数据中心 PUE 的手段。服务器从机房的冷通道一侧进风,排风到热通道,在提高冷通道温度的基础上,增加服务器进出风的温差,节能效果更显著,也意味着机房热通道温度的进一步上升。

提高机房冷通道的温度,可以延长数据中心利用自然冷源的时长,降低年均 PUE,将是东数西算和双碳时代的普遍做法。

先举一个“西算”的例子:华为云乌兰察布预制模块化数据中心送风温度 25℃,回风温度 38℃,相应的,FusionCol 间接蒸发冷却机组(AHU)在室外湿球温度小于 19℃ 时可以只靠风机和喷淋系统为机房供冷,不用开启压缩机补冷,一年开启压缩机的时间不到 30 天,年均 PUE 可低至 1.15。

“东数”所在地没有这么好的自然条件,但即使是相对传统、保守的金融数据中心,也有上海证券交易所金桥数据中心这样的“异类”:送风温度 22℃,热通道温度 35℃。要知道,同期投产的某大行数据中心,冷热通道的温度还是 20℃/25℃的水平。

这些送回风温度较高的数据中心往往还有一个共同点,就是封闭热通道,将整个机房作为冷通道。

封闭热通道,可以采用水平弥漫式送风,无需设计下送风地板,从机房建设的角度能简化、降低投资成本,对机房运维的意义也不容忽视。22~27℃ 是运维人员比较舒适的区间,如果继续封闭冷通道,将整个机房作为热通道,35~38℃ 的高温环境对运维人员显然是很不友好的。

那么,这种变化对服务器有什么影响呢?

传统通用服务器在运维上有一个明显的弊端,即冷热通道都有维护频率较高的部件。暴露在冷通道一侧的是前面板,更换硬盘或 SSD(Solid State Drive,固态盘)的操作主要发生在这里;热通道一侧是后端,除了电源模块(PSU,供电单元)和电源线,主要是网线(包括光纤和光模块),有时也会有硬盘/SSD(用作系统盘)。

△ 中国电子信创云基地(顺义)机房内景,留意远端墙上的送风口

维护一台服务器可能要冷热通道两头跑,特别是热通道那头电源线和各种网线并存,往往比较杂乱,如果温度还很高,操作环境就更差了。

所以国内外大型互联网和云计算公司的超大规模数据中心,已经在部署前维护架构的服务器,譬如前面提到的天蝎整机柜服务器,以及阿里巴巴开源的“方升”项目,都把网络接口和扩展卡(如管理网口、OCP标卡、PCIe卡)、可插拔硬盘/SSD、服务标签、VGA 和 USB 等 IT 运维的部分放在服务器前面,也就是冷通道一侧;服务器后面,即热通道一侧,留给对接基础设施的部分,譬如电源模块和电源线,或者 12V/48V 铜排及风扇墙,如果采用冷板式液冷还有一组水冷管接头。

总的来说,类似的前维护设计,也在一定程度上实现了 IT 运维与基础设施运维的分离。当然,这是个比较概略的归纳,譬如,采用铜排集中供电的方案,连电源模块的更换都可以在冷通道一侧进行。

△ 采用前维护方案的阿里云方升架构(服务器)

前维护架构天然适配液冷方案,包括冷板式液冷和浸没式液冷。不过,由于网络接口和扩展卡会占用相当一部分前面板的空间,前维护架构不太匹配传统的 2U 存储型服务器(可以理解为 2U 通用服务器的重存储配置,如前面板配满 12 个大盘),更适合计算存储分离(存算分离)的整体架构。

公有云服务器提供商已经广泛采用存算分离架构,譬如阿里云基于倚天 710 CPU 的 g8m 实例和腾讯云基于 AMD EPYC 7002/7003 系列 CPU 的 SA2/SA3 实例,存储都采用云(硬)盘。在我们看到的一些星星海服务器的部署场景中,服务器前面原本可以布置硬盘/SSD 盘位和背板的区域都是空的(板载 M.2 和后面的 2 个 2.5 英寸盘位,可安装系统盘),没有需要维护的部分,而且更利于 CPU 散热。

液冷服务器和存算分离架构不会迅速扩散到大多数企业,2U 通用服务器在今后一段时间仍将是国内市场的主流。在天蝎 3.0 技术规范中,不仅支持 1U 和 2U 的节点设计,也支持 2U 的“标准机”,即通用服务器。另一个例子是阿里云基于方升架构的磐久服务器,在官网上放出的两款用于混合云的型号 AS2211TG1 和 AS2212TG4,就是典型的 2U 通用服务器。