以Agent为锚点:re:Invent 2025全栈基础设施革新逻辑与价值拆解

2025年12月2日至4日,拉斯维加斯的AWS re:Invent 2025大会用三天高密度的技术发布与战略解读、现场体验,勾勒出AI从技术爆发迈向规模化应用的清晰路径。

在AWS re:Invent 2025大会第三天的Keynote中,亚马逊云科技公用计算高级副总裁Peter DeSantis明确对基础设施革新的技术拆解,安全性、可用性、弹性与成本优化是云服务的核心属性。

亚马逊云科技正通过大规模投资数据中心、电力与容量建设支撑全球AI转型,并聚焦芯片研发、网络升级与架构创新,以技术突破降低模型构建与工作负载运行成本,为客户打造全栈优化的基础设施解决方案。

亚马逊云科技公用计算高级副总裁Peter DeSantis亚马逊全球副总裁、亚马逊云科技大中华区总裁储瑞松概括re:Invent 2025的关键词:Agent。以3nm芯片、低延迟网络保障Agent运行效率,通过Bedrock AgentCore等全栈能力构建Agent,让算力、平台、模型、数据管理、Agent开发工具形成的协同效应,最终形成对手难以复制的生态闭环。落地层面则以客户案例验证Agent在降本提效上的实际价值,推动Agent从概念走向规模化应用。

亚马逊全球副总裁、亚马逊云科技大中华区总裁储瑞松

芯片革新:双产品线引领性能与成本革命

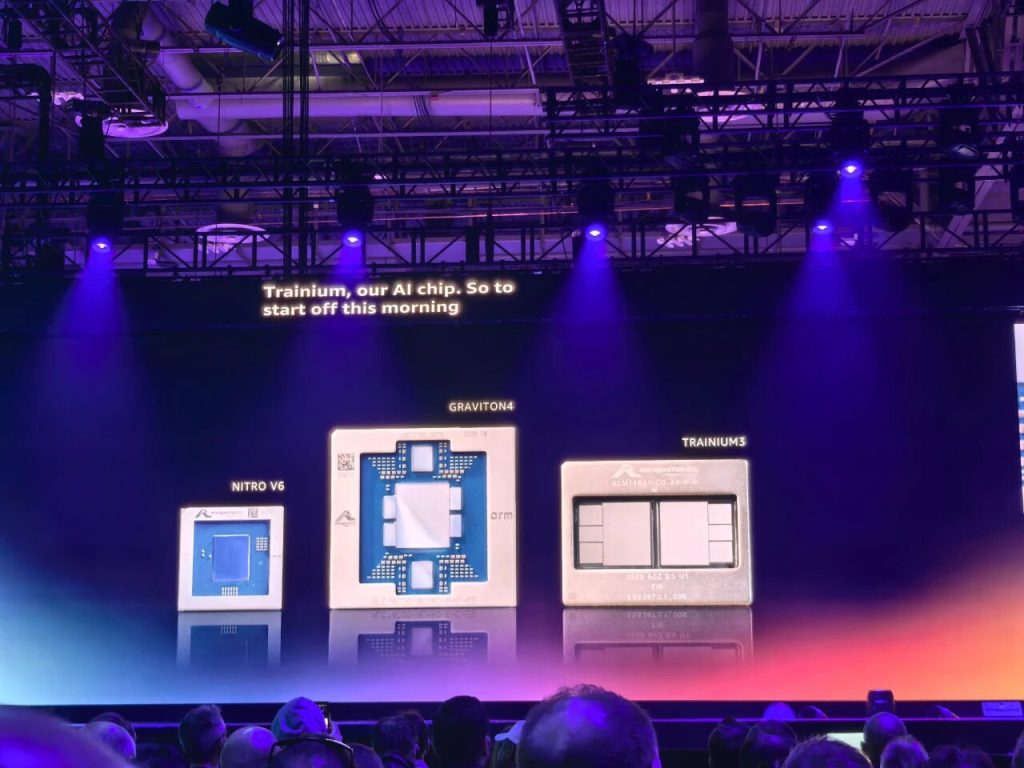

自研芯片是亚马逊云科技基础设施竞争力的核心,此次发布的Graviton5服务器CPU与Trainium3 AI芯片,分别在通用计算与AI算力领域实现关键突破。以此为起点,亚马逊云科技在网络升级、生态协同等方面也展开了一系列动作,勾勒出了其基础设施革新的清晰逻辑。

01Graviton5:3nm工艺下的云原生计算巅峰

作为亚马逊云科技最强大、最高效的自研服务器CPU,Graviton5采用3nm制程与Neoverse V3核心架构,单芯片集成192个核心,核心数较上一代翻倍。这种高密度设计缩短了核心间数据传输距离,通信延迟降低33%、带宽同步提升,能支撑实时游戏、EDA等高频交互场景,通过快速数据交换实现负载灵活扩展。

Graviton5核心性能较Graviton4提升25%,L3缓存容量达到192MB,是前代的5.3倍,每核心可访问的缓存量提升2.6倍,配合DDR5-8800高速内存与PCIe Gen 6接口,大幅降低数据访问延迟,显著提升内存密集型应用效率。Graviton的诞生源于亚马逊云科技对云原生计算的深度思考。在Nitro系统成功验证定制芯片对网络和存储性能的提升价值后,团队提出疑问:“既然定制芯片能改善网络和存储性能,为什么不能应用于计算领域?”由此开启了专为云工作负载从零设计处理器的历程,核心目标是实现最优性价比。

Graviton5 基于 AWS Nitro 系统,利用第六代 Nitro 卡将虚拟化、存储和网络功能卸载到专用硬件。该架构几乎将服务器的所有计算和内存资源直接交付给用户的工作负载,同时实现了零操作员访问设计,从根本上防止任何其他系统或个人登录EC2服务器、读取实例内存或访问客户数据。同时Graviton5引入了Nitro隔离引擎,作为Nitro系统的增强,利用形式验证提供数学确定性,确保工作负载彼此间及AWS操作员之间是隔离的。Nitro Isolation Engine的简约、经过正式验证的代码库采用数学证明,确保其行为完全符合定义,开创了数学验证云安全的新标准。此外,全栈优化能力进一步放大了芯片优势。亚马逊云科技通过“直接贴合芯片”的裸片冷却技术,移除传统CPU的保护顶盖与对应热界面材料,减少热阻传导层级,使风扇功耗降低33%,在控制能耗的同时保障性能释放。实测数据显示,Graviton5在CPU密集型机器学习场景性能提升32%,数据库场景普遍提升约30%,苹果将核心服务迁移后实现40%性能提升与30%成本降低,SAP HANA分析查询性能更是提升60%。同时基于Graviton5的M9g实例(预览版)今日同步发布,相比M8g实例性能提升高达25%,是目前Amazon EC2中性价比最高的实例。

02 Trainium3:3nm AI芯片破解算力瓶颈

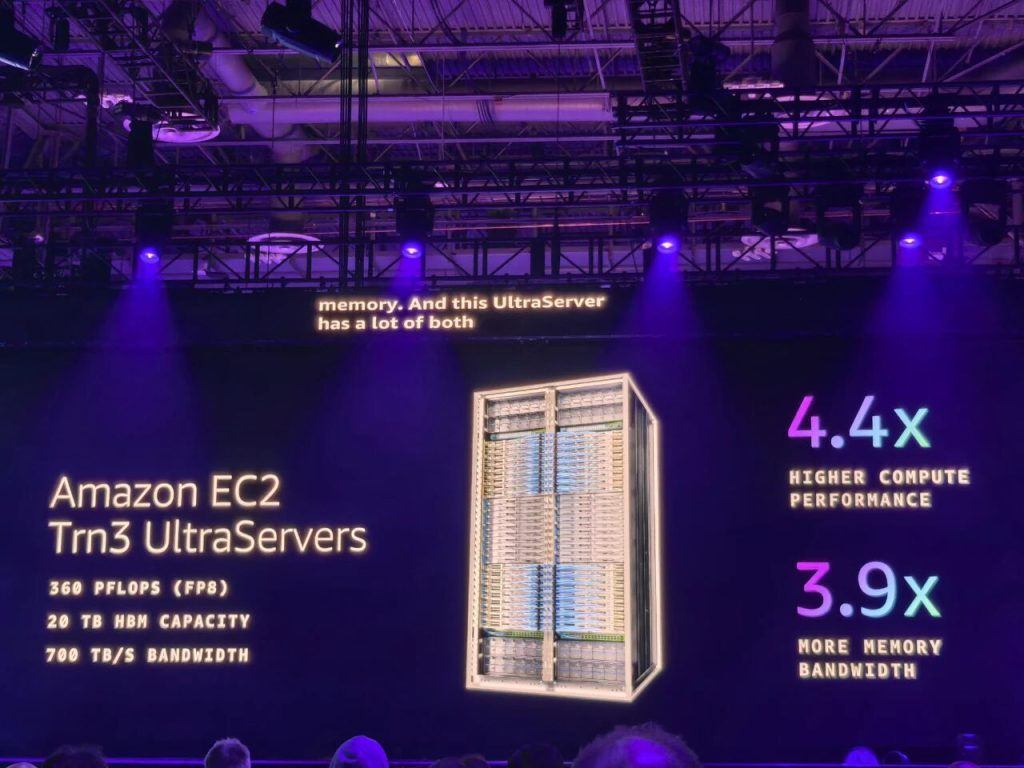

针对AI模型规模扩大带来的算力需求,亚马逊云科技推出首款3nm制程的Trainium3 AI芯片,并基于其打造Amazon EC2 Trainium3 UltraServers(Trn3 UltraServers),现已正式可用。

Trainium3 AI芯片通过先进的设计创新、用于加速芯片间数据传输的优化互连结构以及能够在处理大型AI模型时消除瓶颈的增强型内存系统,实现了突破性的性能提升。除了性能增长之外,Trainium3实现显著的节能效果,与前几代相比能效提升40%,在大规模部署中尤为关键,从而能够提供更具成本效益的AI基础设施,同时降低数据中心的整体能耗与环境影响。与上一代相比,Trn3 UltraServers计算性能提升4.4倍,能效提升4倍,内存带宽提升近4倍,单系统可集成144颗芯片,总算力达362 FP8 PFLOPs。在实际场景中,Trainium3展现出强劲效能:运行OpenAI开源模型GPT-OSS时,单芯片吞吐量提升3倍,响应速度加快4倍,可将模型训练周期从数月缩短至数周。Anthropic、Ricoh等客户已通过Trainium系列将训练与推理成本降低50%,Amazon Bedrock也已在Trainium3上运行生产级工作负载。Trainium3的算力突破需匹配低延迟网络才能释放最大价值,亚马逊云科技通过垂直集成的网络架构,为分布式AI计算打通了数据流动通道。

03 网络升级:构建无延迟的算力协同体系

分布式AI计算的通信瓶颈是行业共性难题,亚马逊云科技通过垂直集成的网络基础设施给出解决方案。Trn3 UltraServers搭载全新NeuronSwitch-v1与增强型Neuron Fabric网络,前者使单台服务器带宽提升2倍,后者将芯片间通信延迟降至不足10微秒。

这种低延迟、高带宽的网络架构,为agent系统、MoE架构等未来AI工作负载提供了数据流动保障,使实时决策系统、无延迟对话式AI等此前难以实现的应用成为可能。对于规模化需求,EC2 UltraClusters 3.0可连接数千台UltraServer,最多搭载100万颗Trainium芯片,规模较上一代提升10倍,能够支撑万亿token级数据集上的多模态模型训练,或为数百万并发用户提供实时推理服务。

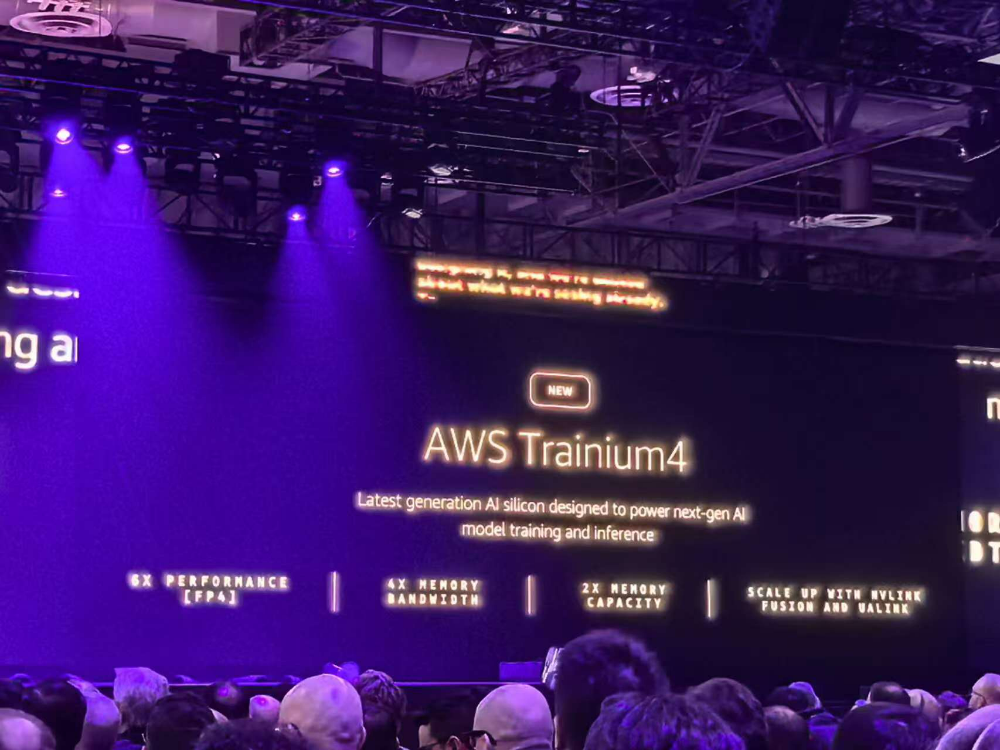

04 未来布局:Trainium4开启跨架构协同

亚马逊云科技已经着手研发下一代Trainium4,其设计目标是在各项性能指标上实现显著提升,包括至少6倍的FP4处理性能、3倍的FP8性能以及4倍的内存带宽,以支撑下一代前沿模型的训练与推理需求。随着硬件与软件的持续优化,最终的整体性能提升将远高于这些芯片参数本身的提升幅度。

Trainium4在FP8性能上的3倍提升是一次基础性飞跃,使AI模型的训练速度至少提升3倍,或处理至少3倍的推理请求,并可通过持续的软件增强与特定工作负载优化获得更多额外加速。FP8作为行业标准的精度格式,能够在现代AI工作负载中平衡模型准确性与计算效率。扩展性革新成为核心亮点:Trainium4将支持NVIDIA NVLink Fusion技术,实现与Graviton CPU、Elastic Fabric Adapter(EFA)在通用MGX机架内的无缝协作,构建兼容GPU与Trainium服务器的机架级AI基础设施,兼顾灵活性与高性能,为高要求AI工作负载提供优化平台。

生态协同:Bedrock工具升级与全栈算力的应用落地

当底层算力与网络基础搭建完成,如何让开发者高效复用这些能力?Bedrock生态与Lambda架构的革新,成为算力落地应用的关键桥梁。

“底层算力支撑+上层应用落地”的全栈协同,是亚马逊云科技释放芯片性能优势的核心逻辑。据AWS第一天主论坛披露,其已部署超100万颗Trainium系列最快型号芯片,而Amazon Bedrock平台上的大部分推理任务均由该芯片驱动。

在此次re:Invent 2025大会上,Bedrock的生态集成能力进一步升级,通过新增工具支持、革新无服务器架构、构建向量存储生态三大举措,让开发者能更高效地将底层算力转化为实际应用价值。

01 Bedrock工具链扩容:构建“模型思考+工具执行”闭环

Bedrock此次新增的四项关键服务集成,从任务执行、开发适配、安全管控到运维监控形成全流程支撑,大幅降低AI应用构建门槛:在此次大会上,Bedrock新增多项工具集成,形成“模型思考+工具执行”的闭环能力:AWS Lambda Tool Calling:实现“模型决策+函数执行”的无缝联动,Bedrock的AI模型可直接触发Lambda函数完成API调用、数据清洗、第三方系统交互等操作,无需额外开发衔接层,快速形成业务闭环。OpenAI /responses API兼容:提供与OpenAI响应API的原生适配,习惯OpenAI开发范式的开发者无需重构代码即可迁移至Bedrock生态,跨平台集成成本降低60%以上。AWS Identity and Access Management (IAM) Permission Management将AWS成熟的身份与访问管理能力深度融入Bedrock,支持按模型、用户、调用场景配置细粒度权限,从根源保障AI应用的合规性与数据安全。Amazon CloudWatch Observability实时采集Bedrock的请求延迟、调用成功率、错误类型等核心指标,结合可视化仪表盘与智能告警,让开发者精准定位推理性能瓶颈,故障排查效率提升3倍。

02 Lambda架构革新:Managed Instances破解无服务器矛盾

作为AWS历史上最具颠覆性的服务之一,Lambda自2014年发布以来已成为现代云架构的核心组件。但传统无服务器模式在专用硬件需求与成本优化上的局限性,迫使部分企业牺牲运维简化优势自行管理基础设施。此次推出的Lambda Managed Instances,彻底解决了这一核心矛盾。

亚马逊云科技Amazon Bedrock产品总监Atul Deo在大会期间,笔者采访了亚马逊云科技Amazon Bedrock产品总监Atul Deo,他认为,Lambda 最大的价值之一在于抽象了底层基础设施,让开发者只需要专注于业务逻辑。最新发布的Lambda Managed Instances,客户可以自己指定驱动某个 Lambda 函数的底层算力和容量。以前在 Lambda 里,这些容量和吞吐都是由服务自动管理的,客户只需要写代码,不会直接看到背后的实例。现在,通过Lambda Managed Instances,客户可以从一系列 EC2 实例类型中进行选择,用这些实例来承载自己的无服务器函数。

03 向量生态落地:S3 Vectors打通AI数据存储瓶颈

除工具链升级外,AWS还发布了以Amazon S3 Vectors为核心的全链路向量能力生态,覆盖从存储、数据库到AI应用的完整链路,共包含10项支持向量处理的服务。作为此次发布的重点,S3 Vectors首次实现对象存储与向量处理的原生融合,解决了大规模AI应用的向量数据存储成本与访问效率难题。

该服务通过优化的存储架构与索引技术,将向量的上传、存储及查询成本降低最高90%,同时支持数十亿级向量的亚秒级检索。与Bedrock的深度集成,使其可直接为RAG(检索增强生成)应用、语义搜索、多模态模型训练等场景提供向量数据支撑——当Bedrock的模型需要调用外部知识时,可通过Lambda Tool Calling快速访问S3 Vectors中的向量库,结合Trainium3的高带宽内存与低延迟网络,推理响应速度提升2-3倍。

结束语

从芯片到网络,从当前产品到未来布局,Peter DeSantis的分享勾勒出亚马逊云科技的基础设施革新逻辑:以全栈优化打破性能瓶颈,以定制化设计降低运营成本,最终让不同规模的企业都能以更低门槛获取AI时代的核心算力。更重要的是,AWS通过此次大会传递出清晰信号:AI的下一个阶段,不再是单点技术的比拼,而是“全栈协同”的竞争。从3nm芯片的电路设计,到万亿token模型的训练支持,再到普通开发者能上手的智能体搭建工具,这不仅是AWS自身的战略升级,更定义了AI规模化落地的新范式:让AI从“少数巨头的游戏”,真正变成了所有企业都能参与的“效率革命”,为Agent(智能体)AI的全面普及按下了“加速键”。